Zanimljivosti

NOSTRADAMUSOVA predviđanja za 2023. godinu RIJEČI KOJE LEDE KRV “Sedam mjeseci Velikog rata, ljudi mrtvi zbog zla”

Knjiga o Nostradamusu u kojoj autor, Mario Reding, tvrdi da je francuski astrolog iz 16. vijeka predvidio smrt kraljice Elizabete II, upozorava da bi pet velikih događaja u 2023. moglo predstavljati veliku prijetnju čovječanstvu.

U svojoj knjizi objavljenoj 2005., “Nostradamus: Potpuna proročanstva za budućnost”, Reding tvrdi da će iduće godine uz prirodne katastrofe biti i neka od najznačajnijih događanja na polju politike i nauke.

Ako se to čini sablasnim, prema brojnim izvještajima, Reding je takođe predvidio pet velikih događaja za 2023. na temelju svojih tumačenja.

“The Sun” izvještava kako je Nostradamus napisao: “Sedam mjeseci Velikog rata, ljudi mrtvi zbog zla.”

Ovo je dodatno zabrinjavajuće uzimajući u obzir trenutnu krizu u Ukrajini i prijetnju Trećeg svjetskog rata.

Publikacija izvještava da bi se predviđanja takođe mogla odnositi na napetost između Kine i SAD-a u vezi s Tajvanom.

(HITC)

Zanimljivosti

BIO DUG I DO 8 METARA: U Australiji pronađeni ostaci praistorijskog morskog psa

Ostaci praistorijskog morskog psa pronađeni su na jednoj plaži u Australiji, a naučnici procjenjuju da je bio dug do osam metara i znatno teži od današnjih velikih bijelih pasa.

Otkriće sugeriše na to da su moderni morski psi dostigli divovske proporcije mnogo ranije nego što se dosad mislilo, piše portal “Diskaver vajld lajf”.

Pronađeno je pet pršljenova starih 115 miliona godina koji su pripadali drevnom lamniformnom morskom psu, redu koji obuhvata i današnje vrste poput velike bijele ajkule.

Iako su pronađeni pršljenovi na obali u blizini grada Darvin na sjeveru Australije bili skoro identični kao kod velike bijele ajkule, postojala je razlika u njihovoj veličini.

Pršljenovi današnjih velikih bijelih ajkula su oko osam centimetara, a pronađeni kod Darvina bili su veći od 12 centimetara, analize su studije objavljene u naučnom časopisu “Komunikejšn biolodži”.

Na osnovu veličine pršljenova, stručnjaci procjenjuju da je životinja bila duga između šest i osam metara i da je bila težila više od tri tone.

Vjeruje se da fosili pripadaju izumrloj vrsti divovskih grabljivih morskih pasa, koji su vladali svjetskim okeanima prije otprilike 100 miliona godina.

Primjerak iz Darvina je 15 miliona godina stariji od svih dosad poznatih pripadnika ove vrste.

(Srna)

Zanimljivosti

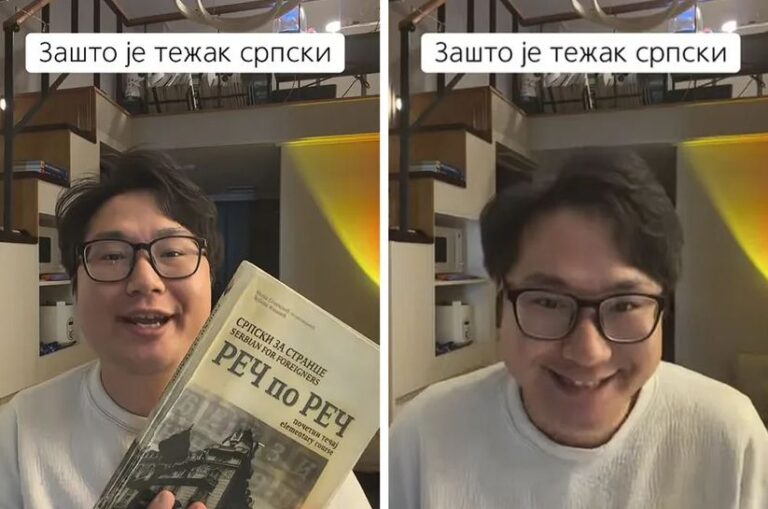

KAKO SE NAJBOLJE UČI SRPSKI? Korejac dao praktičan savjet, a kad vidite šta predlaže smijaćete se cijeli dan!

Mladić iz Koreje, koji se doselio u Srbiju, suočio se sa problemom svakog stranca – učenjem srpskog jezika. Iako je počeo sa standardnim udžbenikom, ubrzo je shvatio da se između književnog i kolokvijalnog jezika krije ponor, a njegov urnebesni zaključak o najboljoj metodi učenja nasmijao je celu regiju.

Korejac je na društvenim mrežama podijelio svoje muke, dajući dva klasična primjera koja najbolje ilustruju razliku između teorije i prakse srpskog jezika.

U udžbeniku piše: “Dobar dan gospodine, kako ste?”

“To Srbi nikada tako neće reći,” konstatovao je kroz smijeh, a potom otkrio kako stvarnost zvuči: “De si tebra moj, ajmo na fuka!”

Drugi primjer ticao se opisivanja lijepih djevojaka, gdje se razlika između formalnog i kolokvijalnog govora još više produbljuje.

U udžbeniku piše: “Vau, ovo je lijepa djevojka”.

“Ali stvarno Srbi, da li vi stvarno pričate tako? Ja sam čuo ovako: ‘Jaoooooj eeee vidi vidi vidi, kakva je ribaaa!’”, objasnio je on, savršeno oponašajući tipičan uzvik oduševljenja.

Ovakvi primjeri, osim čuvenih padeža, objašnjavaju zašto je srpski često noćna mora za strance – prevelika je razlika između standardnog i nestandardnog govora. Ipak, Korejac je ponudio rješenje, i to vrlo… praktično.

Umjesto da se fokusira na udžbenike, Korejac je ponudio revolucionarnu metodu za savladavanje srpskog jezika.

“Najbolji način da naučite srpski nije da se fokusiramo na knjigu ovako, nego da se fokusiramo na rakiju. Onda pijemo svakog dana rakiju sa Srbima i onda je to to. To ti je život, to je udžbenik srpskog jezika,” zaključio je on, izazivajući lavinu oduševljenih komentara.

Njegova teza o neformalnom pristupu i “rakijskoj metodi” naišla je na potpunu podršku Srba.

“Ne zovemo džabe kafanu biblioteka,” poručio je jedan korisnik.

“Bravo, ništa bez rakije, aj živjeli,” dodao je drugi, uz opasku: “Rakija spaja ljude!”

Komentari o njegovom izgovoru su se samo nizali: “Pa ti bolje pričaš nego ja”, “Fenomenalno pričaš Srpski… prosto nevjerovatno…”, a najviše pohvala dobio je upravo za svoj duhoviti, ali precizni, zaključak, prenosi “Telegraf”.

Korejac je, sudeći po reakcijama, pronašao ne samo najbolji udžbenik srpskog jezika, već i ključ za srpski mentalitet. A taj ključ je, naravno, u čašici!

Zanimljivosti

NAJŠKOLOVANIJI PASTIR! Život među ovčijim stadom u Studenici

Osamdesetjednogodišnji Radivoje Jojlija, magistar bioloških nauka i profesor u penziji, već 15 godina čuva stado ovaca Manastira Studenice.

Na manastirskoj ekonomiji dočekao je novinarsku ekipu u odijelu kakvo je nosio i u učionici, jedino je šešir zamijenio šajkačom. Ovce ga vole, a on svojom biografijom mijenja stereotipe o pastirima. Godinama je bio naučni radnik u Zavodu za zaštitu prirode u Sarajevu, magistar, doktorand…

– Bio sam na dobrom putu da završim doktorat, ali sam izgubio smisao za to, nisam vidio smisao više u tome – objašnjava 81-godišnjak za RTS.

Radivoje Jojlija je danas jedini pastir na studeničkim pašnjacima.

– Nisam bio jedini, bilo nas je četvorica tada, bilo je puno ovaca, jedno tri puta više nego sada – priča nesvakidašnji pastir koji po vrletima gazi sigurnim korakom dok pridržava leđa.

Rođeni Nevesinjac u Studenicu je stigao 1995. godine. Sa suprugom i tri kćerke izbjegao je iz Sarajeva. U pomoć mu je prvo priteklo manastirsko bratstvo.

– Ja se zaista nadam da je on našao mir ovdje među nama. Nadam se da je i njemu dobro kao što je i nama što je on ovdje, što nam je ovako za ponos i ugled. Mnogi gosti se zaprepaste kad im kažemo da imamo jednog od najškolovanijih pastira u Srbiji – kaže jeromonah Vitalije iz Manastira Studenica.

Možda većinu vremena provodi među ovcama, ali je za mještane i komšije pastir među ljudima. Kažu da je duša od čovjeka i da se ne stidi nijednog posla da radi ali da neće da traži pomoć.

Bio je, kažu, i poseban nastavnik jer nije samo predavao biologiju, već je djecu učio pravim vrijednostima.

– On je predivan čovjek, imao je dosta učenika tu, nažalost, svi su otišli iz ovog mesta, nisu više tu – priča jedna mještanka.

Otišle su i Radivojeve kćerke, ali ga redovno obilaze, a on vrijeme između posjeta najradije prekrati čitajući knjige među ovcama o kojima će, kaže, brinuti dok ga noge nose, prenosi Srpskainfo.

-

Politika1 dan ago

Politika1 dan agoVUKOVIĆ UPOZORAVA: Proglašenje “Muslimanskog bratstva” terorističkom organizacijom otvara ozbiljna pitanja za BiH

-

Region1 dan ago

Region1 dan agoU TUMORU GENERALA PAVKOVIĆA PRONAĐEN URANIUM I TEŠKI METALI: “Revolucionaran dokaz o posljedicama NATO bombardovanja”

-

Politika3 dana ago

Politika3 dana agoUPRKOS HELEZOVOJ ZABRANI Sijarto sletio u Banjaluku

-

Politika1 dan ago

Politika1 dan agoŠOKANTNO! Šta sve od imovine ima “PREPOŠTENI” Luka Petrović, direktor ERS-a?

-

Politika2 dana ago

Politika2 dana ago“ĆUTOLOG” NA NAJPLAĆENIJOJ FUNKCIJI! Šljivićeva sjela u RUGIPP dok 16 doktora nauka čeka posao

-

Politika3 dana ago

Politika3 dana agoŠLJIVIĆ ODGOVORILA GRAHOVČEVOJ: „Moje diplome su u Narodnoj skupštini, a salon ljepote ne znači da nisam pravnik“

-

Svijet2 dana ago

Svijet2 dana agoPROCURIO VOJNI PLAN NJEMAČE U SLUČAJU SUKOBA SA RUSIJOM: Brza mobilizacija 800 hiljada NATO vojnika

-

Politika1 dan ago

Politika1 dan agoOTKAZI U GrO SNSD BANJALUKA: 15 ljudi ostalo bez posla